ShapeLLM-Omni är en helt ny typ av multimodal AI-modell som inte bara förstår och genererar textual content och bilder, utan även 3D-objekt. Det här är ett stort steg framåt för AI-världen, där tidigare modeller som GPT-4o varit begränsade until tvådimensionella medier. ShapeLLM-Omni är byggd för att förstå, generera och redigera 3D-resurser – och kan kombinera dessa med textual content och bilder i valfri ordning.

Hur fungerar modellen?

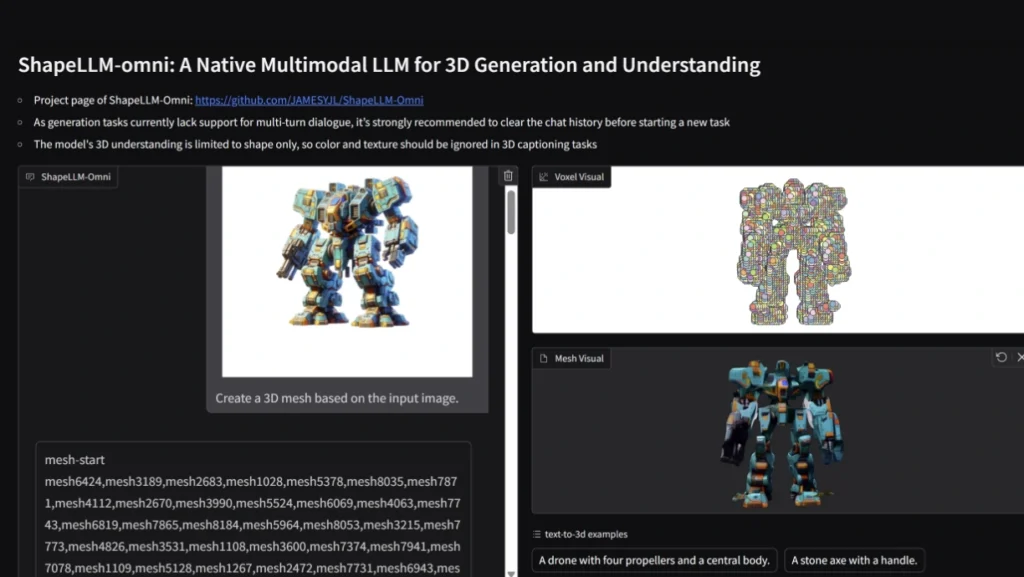

Kärnan i ShapeLLM-Omni är en avancerad 3D Vector-Quantized Variational Autoencoder (VQVAE). Den här komponenten omvandlar 3D-objekt (t.ex. mesh-modeller) until en diskret sekvens av tokens, vilket gör det möjligt för modellen att bearbeta 3D-data på samma sätt som textual content eller bild.

Modellen använder en voxelbaserad illustration (64³ voxelgrid) som komprimeras until en mindre latent illustration (16³ grid) och därefter until 1024 diskreta tokens per objekt. Dessa tokens används sedan av språkmodellen för att generera, förstå och redigera 3D-innehåll.

För att träna modellen har forskarna byggt ett gigantiskt dataset kallat 3D-Alpaca, med över 700 000 högkvalitativa 3D-resurser och miljontals exempel på text-till-3D, bild-till-3D, 3D-till-text och 3D-redigering.