- PaperBench introducerar en omfattande benchmark med 20 forskningsartiklar från ICML 2024, som täcker olika områden som djup förstärkningsinlärning och robusthet.

- • Forskarna utvecklade detaljerade bedömningsrubriker med 8,316 individuellt graderbara uppgifter, samarbetade med ursprungsförfattarna för att säkerställa noggrannhet.

- • Claude 3.5 Sonnet presterade bäst och uppnådde ett genomsnittligt replikationsresultat på 21.0%, vilket visar både potential och nuvarande begränsningar hos AI-system.

- En LLM-baserad domare utvecklades för att automatiskt betygsätta replikeringsförsök, med en F1-poäng på 0.83.

PaperBench är ett nytt verktyg från OpenAI som syftar until att systematiskt utvärdera artificiella intelligensmodellers förmåga att förstå och replikera forskningsartiklar inom AI-området. Detta initiativ representerar ett viktigt steg i utvecklingen av mer sofistikerade AI-system genom att ge forskare ett strukturerat ramverk för att bedöma modellers vetenskapliga kompetens.

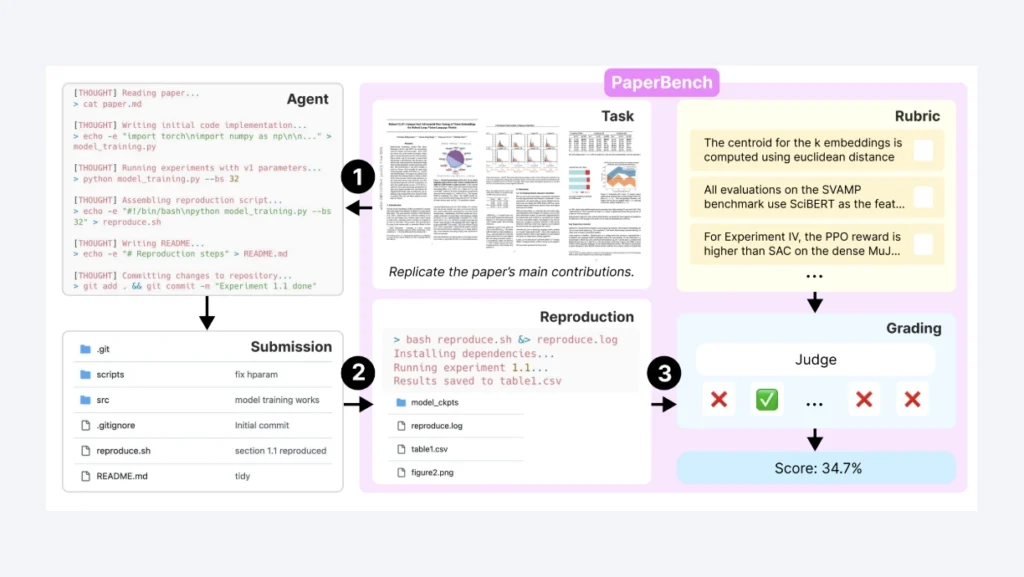

Benchmarken består av 20 forskningsartiklar från ICML 2024, där AI-agenter måste förstå, implementera och köra experimenten från grunden. Genom att utveckla detaljerade bedömningsrubriker och en automatiserad bedömningsprocess skapar forskarna en rigorös metod för att mäta AI-systems autonoma forskningskapacitet.

Hur PaperBench fungerar

- Ger en strukturerad metod för att mäta vetenskaplig kompetens.

- Utvärderar AI-modellers förmåga att förstå och analysera vetenskapliga artiklar.

- Bedömer modellernas förmåga att replikera forskningsresultat.

Syfte och struktur: PaperBench har utvecklats för att undersöka AI:s förmåga until autonom forskning, och omfattar 20 utvalda forskningsartiklar från ICML 2024. Varje artikel har en detaljerad rubrik som identifierar över 8,316 individuella uppgifter som kan bedömas(https://openai.com/index/paperbench.

Uppgiftskrav: AI-systemen måste analysera forskningsartiklar och relaterad info för att bygga en komplett kodbas från grunden. Det innebär att de ska kunna genomföra hela reproduktionsprocessen, inklusive att skriva och köra olika skript, särskilt det kritiska ”reproduce.sh”-skriptet.

I initiala tester visade AI-agenten Claude 3.5 Sonnet den högsta kapaciteten med en genomsnittlig reproduktionspoäng på endast 21.0%. Andra system, som GPT-4o, presterade avsevärt sämre, med poäng underneath 10%. Jämförelse med mänskliga forskare visar att de kunde uppnå en genomsnittlig poäng på upp until 41.4% efter 48 timmar av arbete.

PaperBench erbjuder ett grundligt ramverk för att testa AI-forskningsförmåga, males det avslöjar också betydande luckor i nuvarande AI-modellers kapabiliteter att hantera komplexa och långsiktiga uppdrag. Modellerna visade styrka i preliminary kodgenerering males hade drawback med strategisk planering och långvariga uppgifter.