LMArena har lanserat en ny betaversion av sin plattform, Den nya webbplatsen beta.lmarena.ai ger användare möjlighet att jämföra olika språkmodeller (LLM) och rösta på vilken som presterar bäst baserat på deras egna prompter. Until skillnad från andra AI-utvärderingsverktyg som fokuserar på tekniska mätvärden, går LMArena en annan väg genom att låta vanliga användare bedöma AI-svar baserat på subjektiva kriterier som användbarhet, relevans och kvalitet.

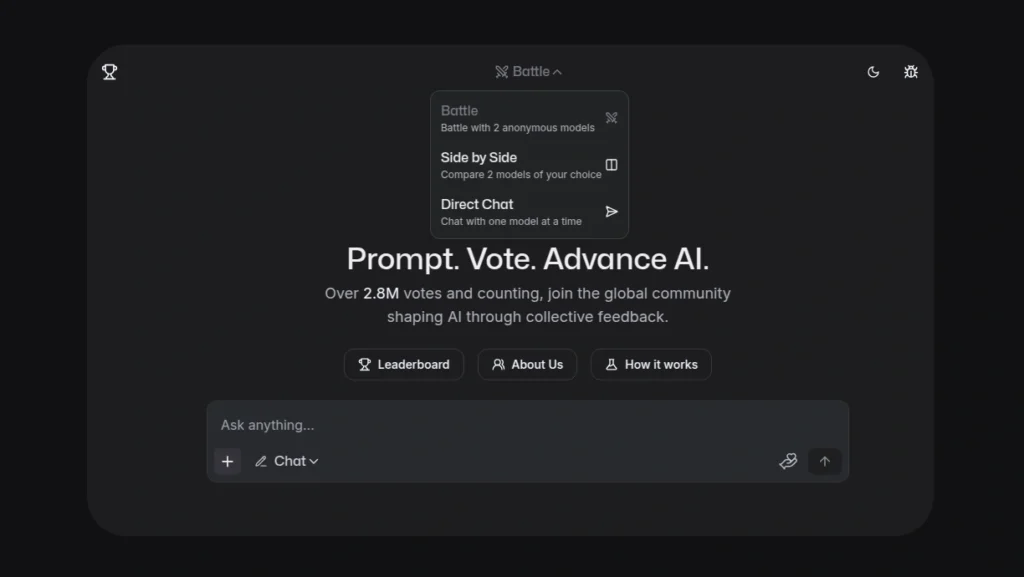

Den nya plattformen låter användare testa och jämföra AI-modeller på två olika sätt: Battle – Här kan användare jämföra två anonyma modeller samtidigt. Detta skapar en ”blindtest” state of affairs där användare kan bedöma svaren utan att veta vilken modell som genererat dem.

Aspect by Aspect – I detta läge kan användare jämföra två modeller av eget val direkt bredvid varandra, där man tydligt ser vilken modell som genererar vilket svar. Det finns också ett ”Direct Chat”-alternativ där användare kan chatta med en enskild modell åt gången för att djupare utforska dess kapacitet.

Jag ställde frågan: ”Who would win in a struggle between John wick and Neo from Matrix” – jag tyckte resultatet från höger var bäst strukturerad och röstade på den vilket visade sig vara Claude 3.5.

Betaversionen har redan samlat in över 2,8 miljoner röster från användare världen över. Denna kollektiva suggestions används för att förbättra AI-modeller och hjälper utvecklare att bättre förstå hur användare interagerar med och värderar olika aspekter av språkmodellernas förmågor.

Plattformen öppnar upp möjligheter för empirisk forskning och utveckling genom att göra det möjligt för användare att bekräfta eller ifrågasätta påståenden om LLM:s effektivitet i realtidsscenario, samtidigt som den bidrar until gemenskapens kollektiva insikter om AI-modellers prestanda.