Meta MoCha är ett banbrytande AI-system som utvecklats av Meta i samarbete med College of Waterloo, designat för att generera animerade karaktärer med tal som är tillräckligt avancerade för filmproduktion. Detta system kan skapa kompletta karaktärsanimeringar med synkroniserat tal och naturliga rörelser, vilket möjliggör en ny nivå av realism i digital filmkonst.

MoCha genererar fullständiga karaktärsanimeringar utan att behöva några yttre referenspunkter som bilder, skelett eller andra hjälpmedel. Detta är ett stort steg framåt jämfört med tidigare tekniker som ofta krävde omfattande manuellt arbete eller ytterligare indata för att skapa realistiska animationer.

De flesta befintliga videogenereringsverktyg fokuserar antingen på realistiska miljöer (som Pika, Sora) eller ansiktsanimation med begränsade uttryck (som SadTalker eller Hallo3). MoCha tar ett helhetsgrepp på problemet genom att skapa fullständiga karaktärsanimationer med naturliga rörelser som ser nästan filmklara ut.

Detta öppnar upp enorma möjligheter för filmskapare, spelutvecklare och digital innehållsskapare som kan använda tekniken för att snabbt generera karaktärsanimationer utan att behöva omfattande manuellt arbete.

Hur det fungerar

För att skapa en animerad scen behöver du bara två saker

- Ett ljudklipp med talet – som styr läppsynkronisering, känslouttryck och gester

- En textbeskrivning som beskriver karaktären, scenen och handlingen.

Från dessa två enkla källor kan AI:n skapa fullständiga karaktärsanimeringar som inte bara synkroniserar läpprörelser med tal, utan även inkluderar naturliga kroppsrörelser, ansiktsuttryck och gester som passar innehållet.

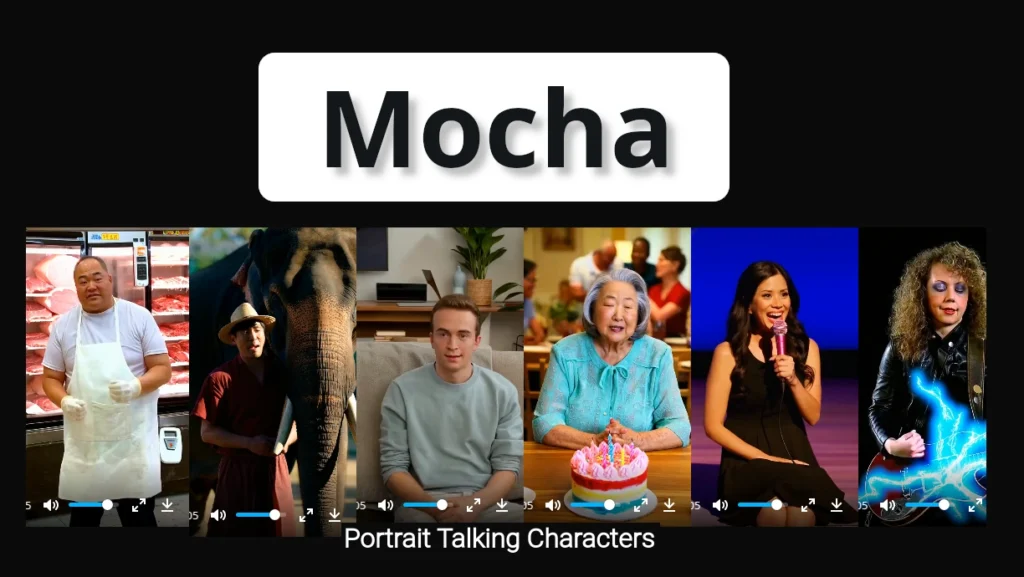

För att verkligen förstå kraften i denna nya teknologi är det bäst att se den i aktion. Meta har delat flera demonstrationsvideos som visar MoCha:s förmågor på projektets officiella webbplats: congwei1230.github.io/MoCha

Du kan se exempel på Meta MoChas imponerande animationer i denna video:

Meta MoCha AI Animation Demo